資訊理論

資訊理論(粵拼:zi1 seon3 lei5 leon6;英文:information theory)係一套數學理論,專研究資訊要點量化、

掟一個銀仔有兩個可能結果,而擲一粒六面骰有 6 個可能結果。擲骰仔當中有更多可能性喺度,所以不確定程度亦都更大-有更高嘅資訊熵;一個人知道咗一次掟銀仔或者擲骰仔嘅結果嗰陣,佢會清楚知道結果-資訊熵變成 0。對比兩個情況,「話俾人知掟銀仔嘅結果」俾到嘅資訊(消除嘅資訊熵)少過「話俾人知擲骰仔嘅結果」所俾嘅。由呢個例子睇得出,資訊理論做到將資訊呢個概念量化,令資訊成為喺科學上可以攞嚟研究嘅對象[4]。

資訊理論自從廿世紀中以嚟就一路都有影響力:資訊理論係由美國電機工程師克勞迪山農喺 1948 年諗出嚟嘅,嗰陣時山農喺度研究訊號處理,跟手出咗佢篇著名論文《通訊嘅數學理論》,喺篇文當中提出咗資訊理論嘅諗頭[5];自從嗰時開始,資訊理論就俾人廣泛噉用落去好多領域度,好似係「啲數據要點壓縮」同頻道容量等嘅研究課題都會用到資訊理論,包括 CD、手機、互聯網、語言研究同埋對黑洞嘅理解... 等嘅多種技術同理論都係有資訊理論先至搞得成嘅[6][7]。

到咗廿一世紀初,資訊理論經已有龐大嘅概念體系,企

基本諗頭

[編輯]資訊理論研究嘅,係資訊[歐 1]嘅傳遞、處理、提取同運用。抽象啲噉講,資訊可以定義做

| 「 | 」 |

資訊理論創始人克勞迪山農係噉樣諗嘅:佢提議將資訊諗做一個包含咗多種可能性嘅集,而[註 3]

- 傳資訊嘅人會用某啲訊號嚟表示自己想傳達嘅資訊;

- 訊號會經過有雜音嘅管道傳到去收資訊嘅人嗰度;

- 例:Syu6 可能會或多或少走樣。

- 收資訊嗰個人要由收到嘅訊號嗰度,按佢對嗰種訊號嘅理解,重新建構返傳資訊嗰個人想表達嘅內容;

管道雜音表示,收訊人唔能夠 100% 肯定佢收到嘅訊號真係完美噉反映傳訊人想表達嘅內容,頂嗮櫳都只係做到盡力令出錯嘅機率有咁低得咁低[14]。

舉個例說明[15][16],想像家陣有個黑盒,個盒裝住啲嘢,A 君唔知個盒裝咗乜(不確定),但佢識 B 君,而 B 君睇過個盒嘅內容;想像家陣 B 君用把口講俾 A 君聽個盒裝咗乜,喺呢個過程當中,B 君要將自己嘅所思所想轉化講嘢嘅聲(訊號),而啲聲會由佢把口傳過去 A 君對耳仔嗰度,A 君個腦就會由聽到嘅聲嗰度解讀 B 君想表達嘅內容(重新建構);假設 B 君係靠得住嘅,A 君就可以透過收訊號嚟判斷個盒嘅內容係乜(減少不確定)-B 君講嘢向 A 君傳遞咗資訊;喺現實,呢種做法好多時都係唔完全靠得住嘅(有雜音),例如可能佢哋兩個周圍嘅環境好嘈,搞到 A 君聽錯。

同樣嘅概念可以用嚟理解好多領域嘅研究:

- 做通訊嗰陣,傳訊嘅人會以某啲方法-好似係文字訊號或者摩斯碼呀噉-向收訊嘅人傳達訊號(將資訊用訊號表達),收訊嘅人收到訊號之後要按照佢對嗰種訊號嘅認識解讀傳訊嘅人想講嘅嘢(重新建構),並且知道對方想表達啲乜(減少不確定)[17];呢種過程喺電子工程同資訊科技上都要應付;

- 用神經科學嚟做例子-對眼嘅視網膜上面每一粒感光細胞喺受到外界嘅光刺激嗰陣,會向個腦嘅視覺區域射神經訊號,而個訊號嘅物理性質-例如係頻率-會按照佢感覺到嘅光嘅屬性而有所不同,例如係光嘅強度同射訊號嘅頻率成簡單正比,

- ,當中 係訊號嘅頻率, 係一個固定嘅常數,而 係光嘅強度(將資訊用訊號表達),

- 呢啲訊號跟住會上腦,話俾個腦知佢睇到啲乜(可能有雜音嘅管道),而個腦本來唔知眼前有啲乜嘅(不確定),但佢由感光細胞嗰度收到神經訊號,知道 ,再解讀訊號得知 (重新建構),就知眼前有啲乜嘢(減少不確定)[18]。

|

資訊量

[編輯]資訊理論作為一套科學理論,首要嘅嘢係將資訊呢個核心概念量化。可以用以下嘅思路嚟諗[19]:

- 首先,如果話一個過程俾出某啲資訊,噉啲資訊描述嘅事件一定係帶些少不確定嘅。完美確定嘅事件係唔使資訊嘅,因為結果發生嘅概率係 100%,結果唔使估都知。

- 噉即係表示,用嚟量度資訊嘅指標實會涉及資訊描述嘅事件嘅概率同概率分佈-例如資訊熵噉,資訊熵量度一個有隨機性嘅變數含有幾多資訊,係個隨機變數嘅概率分佈嘅一個特性(下面詳講),而相互資訊係兩個隨機變數嘅聯合概率分佈嘅一個特性(下面詳講),反映一個有雜音嘅管道當中可靠溝通嘅最大可能率。

喺以下嘅內容當中, 會按照慣例當做 0,因為無論對數()基數係幾多, 都會成立。

資訊熵

[編輯]

資訊熵[歐 3](數學符號係 )[註 1]係資訊理論嘅根基之一。是但攞個變數,個變數都會有若干個可能數值,例如「某年某月某日某刻掟某個銀仔」呢個變數嘅可能數值大致上有兩個-公同字。每個數值都會有一定嘅機會率出現,而描述每個可能數值出現嘅機會率嘅就係所謂嘅概率質量函數。知道咗某件事件嘅概率質量函數之後,件事件所帶有嘅資訊熵可以用以下呢條式計[1]:

- ;

喺呢條式當中,

- 係指第 個可能性發生嘅概率,

- 係 以 2 做基數嘅對數。

成條式用粵文解釋就係:

| 「 | 」 |

用呢條式計嘅話,掟一粒冇出千嘅銀仔-即係話公同字出嘅概率都係 50%-呢件事件帶嘅資訊熵()係[20]:

- ;

喺直覺上,呢條式係量度緊件事件含有嘅不確定。資訊理論家之所以會揀呢條式嚟計資訊熵,係因為喺可能嘅算式當中,淨係得呢條符合佢哋心目中「一條計不確定嘅算式」應有嘅特性[21]:

- 一件肯定嘅事件係理應冇資訊熵嘅()-而如果其中一個可能性嘅概率等如 1(第啲可能性機會率冚唪唥等如 0), 條式會出 0;

- 另一方面,每個可能性嘅概率都一樣(最唔確定)嗰陣, 俾嘅數值會去到最大。

除此之外, 仲有以下呢啲重要特性:

- 嘅單位係位元或者必(粵拼:bit1) 。有啲研究者會用 2 以外嘅數嚟做上面條式個對數嘅基數嘅,不過道理都一樣,例如用 做基數嘅話,條式就會俾出以位元組[歐 4]作為單位嘅資訊熵[22]。

- 算式嘅一個特殊情況,係得兩個可能值嘅隨機變數,例如掟銀仔嘅結果。喺呢個情況下,兩個可能性嘅概率加埋實會係 1—,當中 同 係兩個可能情況分別嘅概率,而呢件事件條資訊熵式就係所謂嘅二元熵函數[歐 5]。條式係噉:

- -係將 應用落去「得兩個可能性」嘅情況嘅樣。

- 想像家吓有個資訊源,資訊源傳送一串有 N 個符號嘅資訊,而每個符號都係獨立同分佈[歐 6]嘅-即係一個符號係乜唔會影響嗰串嘢入面第啲符號係乜,而且每個符號嘅概率分佈相同,例如一串互不相干、每個都係隨機噉揀嘅英文字母-呢串嘢嘅資訊熵係 (當中 係每一個個別符號嘅資訊熵)咁多位元;而如果呢串嘢係同分佈(每個符號概率分佈相同)但係唔獨立(一個符號係乜可以影響第啲符號係乜)-例如係一篇用粵文寫嘅文章噉,如果佢某一橛係資訊呢隻詞嘅話,噉呢隻詞嘅下一格好大可能係係字-喺呢種情況下,串嘢嘅資訊熵實會細過 。

- 如果有個人傳遞 1,000 位元(0 同 1)咁長嘅數碼訊號,收訊號嗰個人喺訊號傳出前經已完全噉知道嗮每一個位元係 1 定 0,噉傳訊號嗰個人冇傳達到任何新資訊-收訊號嗰個人收到訊號前後 都係 0,所以呢串訊號傳咗出去並冇消除任何 。但如果喺收訊號嗰個人眼中嗰 1,000 個位元每一個都係 50% 機率係 1、50% 機率係 0 嘅話,噉用 嚟計,佢透過接收呢串訊號會收到 1,000 位元咁多嘅資訊。

聯合熵

[編輯]聯合熵[歐 7]()係指兩個隨機變數 同 嘅共同資訊熵。條式係噉嘅[23]:

- ;

當中 係指「 同時 嘅概率」,成條式道理同基本嗰條資訊熵式道理一樣,都係諗嗮所有可能性,將每個可能性嘅概率乘以個概率嘅對數,跟手再將所有可能性嘅呢個數加埋一齊。假如 X 同 Y 係獨立[歐 8](其中一個數值係乜唔會影響另一個數值係乜)嘅,佢哋嘅聯合熵會等同佢哋各自嘅資訊熵相加,噉係因為當兩件事件係獨立嗰陣,以下呢條式會成立[23]:

- ;

- ;喺數學上已知,所以綜合呢兩條式,

- ;

條件熵

[編輯]假如家吓有兩個隨機變數 同 ,收資訊嗰個人知道 同 唔係獨立,而係有統計相關嘅-即係 嘅數值係乜能夠一定程度上預測 嘅數值係乜。喺呢種情況下,假設而家嗰個人經已知道咗 嘅數值,但要預測 嘅未知數值[歐 9],呢種情況下嘅熵就係所謂嘅條件熵[歐 10],而

- 「喺知道 嘅數值下預測 」嘅資訊熵

就係「 喺 上嘅條件熵」[24]。

舉個例子說明,家吓個人面前有隻大壞狼,佢想預測隻狼有冇食佢落肚嘅意慾:根據佢對狼嘅認識,佢知道如果隻狼個樣係「慢慢噉行緊埋嚟,而且開始流口水」嘅話,「隻狼想食我落肚」嘅概率會比較大;而如果隻狼個樣係「打緊喊露,眼尾睄咗我一吓就冇再望」,噉「隻狼想食我落肚」嘅概率會比較細,所以隻狼個樣能夠預測隻狼想食我嘅意慾。喺呢個情況下,

- 「基於隻狼個樣嚟預測隻狼想食我嘅意慾」嘅資訊熵

就係所謂嘅條件熵[24]。

要計條件熵,就會用到條件概率[歐 11]嘅概念,例如「已知 , 嘅條件概率」( 已知 )係指當 , 嘅概率。呢個條件熵嘅計法如下[24]:

- ;

當中 係指「當 嗰陣, 嘅機會率」。呢條式嘅第二行係指「考慮 嘅每個可能數值,再考慮喺每個 可能數值下嘅 嘅可能數值,加埋嗮喺嗰個 數值之下每個 嘅可能性嘅條件概率乘條件概率對數,跟手再加埋嗮喺 唔同可能數值當中得到嘅呢個值」,而第二行嗰條式之所以可以變做第三行嗰條,係因為條件概率條式[24]:

同時:

相互資訊

[編輯]喺考慮兩個隨機變數嗰陣時,相互資訊[歐 12]指嘅係觀察第一個變數能夠得知嘅有關第二個變數嘅資訊。呢個數字可以幫手計點將傳訊號同收訊號嗰時傳到嘅資訊量最大化。假想家吓有兩個隨機變數 同 , 相對於 嘅相互資訊係噉計嘅[25]:

- ;

呢條式有以下呢啲特性[25]:

- 當 同 係完全獨立()嗰陣, 計到嘅結果係 0,即係話當兩個變數完全唔啦更嗰時,睇其中一個變數唔會幫到手預測另外嗰個。

- ,所以傳有關 嘅訊號嗰陣,知道 嘅數值平均可以慳返 咁多位元。

- 條式係對稱[歐 13]嘅:

相對熵

[編輯]相對熵[歐 14]係一種比較兩個分佈嘅方法:想像家吓有個生物學家想研究狼嘅重量,隻隻狼嘅重量都唔同,所以狼呢個總體當中喺重量上有個概率分佈-假如有(例如)30% 嘅狼重量介乎喺 80 至 85 kg 之間,有 20% 嘅狼重量介乎於 85 至 90 kg 之間... 呀噉,噉是但隨機抽一隻狼嚟睇,佢會有 30% 概率係重量處於 80 至 85 kg 之間嘅。個生物學家手上嘅數據會顯示出一個概率分佈 ,但呢個分佈未必會等同真實嗰個分佈 [26]。

想像而家個生物學上想將佢手上啲數據壓縮(等柞數據易儲啲),個相對熵()量度緊嗰兩個分佈之間有幾大差異,條式係噉嘅[27]:

- ;

當中 係指「根據 , 嘅機率」。相對熵可以按照「平均嚟講知道個真相會做成幾大嘅驚訝」嚟理解:想像有一個帶有隨機性嘅變數 ,佢真實嘅概率分佈係 ,而家係噉抽 嘅數值,如果 A 君知 嘅樣,而 B 君心目中嘅分佈係 ,噉平均嚟講 B 君會有更多嘅驚訝(更加常會估錯 嘅數值)。所以相對熵條式可以話係反映 B 君嘅驚訝減 A 君嘅驚訝[27]。

傳資訊

[編輯]資訊源

[編輯]

資訊源[歐 15]係指一個曉係噉傳送訊號嘅過程,大致上可以分做無記憶同有記憶兩種:無記憶嘅資訊源唔曉用任何方式記住佢自己過去傳過嘅資訊,所以佢喺是但一個時間點,傳嘅訊號都唔會受過去傳過嘅訊號影響,佢射嘅訊號冚唪唥都係獨立同埋符合某個分佈嘅;相對嚟講,有記憶嘅資訊源能夠用某啲方式記住佢過去傳過嘅資訊,令到過去嘅資訊能夠影響未來嘅資訊[28]。

熵率

[編輯]熵率[歐 16]()係指個資訊源傳送嘅符號嘅平均熵。喺無記憶嘅資訊源當中,呢個數只係每個符號各自嘅資訊熵-每個符號都有啲可能數值,而每個數值都有一定機率出現,可以用返 嚟計;而當個資訊源係有記憶嘅[註 5],就要用以下呢條式計[29]:

- ;

即係知道咗個資訊源之前傳過乜嘢訊號之後,嚟緊個訊號係乜乜嘅條件概率。呢條式廣義化[歐 17]嘅話可以變做:

- ;

編碼理論

[編輯]編碼理論[歐 18]係資訊理論嘅一個子領域,專門研究將資訊編碼做訊號嗰陣點樣令效率有咁大得咁大,又同時令誤差有咁細得咁細。舉個例說明,

都係表達緊同一句粵語句子,不過用咗唔同方法將句嘢寫低,而呢啲唔同方法喺唔同時地效率可能會唔同,例如如果傳訊嗰個人唔熟漢字輸入法、打起字上嚟冇咁快手嘅話,要佢用漢字表達嗰句嘢效率就可能會低啲。除咗噉,數據壓縮同錯誤檢測等都係編碼理論上重要嘅課題[30]。

下圖係摩斯碼嘅圖解。喺摩斯碼當中,每個字母同數字都對應一串 . 同 - 嘅組合。

壓縮

[編輯]數據壓縮[歐 19]涉及傳資訊嘅人嘗試用少啲位元嚟表達佢份資訊。舉個例說明,家陣 A 君想遠距離向 B 君傳送 wikipedia 呢隻英文字,佢部電腦嘅做法可以係

- 每個羅馬字母都俾個 5 個位嘅二進制代碼佢,例如

00000代表 A、00001代表 B、00002代表 C...,要部電腦內部將隻字用一個 45 個位長嘅代碼嚟表達,跟手再傳呢段代碼俾 B 君部電腦,而 B 君部電腦會解讀呢段碼,再顯示出嗰隻字; - 另一方面,A 君部電腦又可以用個聰明啲嘅方法,常用嘅字母(例如係啲元音)就用 2 至 3 個位長嘅代碼表達,而冇咁常用嗰啲(J 同 Z 呀噉)先用 5 個位長嘅代碼,噉傳 wikipedia 呢個字嗰段代碼實會短過 45 個位。

-用唔同嘅方法入碼能夠幫到手喺傳送訊號嗰陣用少啲位元,傳一個單字嗰陣會慳幾個位元,傳幾千幾萬字長嘅文章嗰陣就會慳數以萬計嘅位元,而事實係,現代嘅家用電腦入面閒閒哋有幾百幾千個呢啲噉嘅檔案,所以數據壓縮法幫手慳咗好多位元[30]。

頻道模型

[編輯]- 一條二元對稱頻道[歐 20]係指一條頻道每個符號得兩個可能數值,而收到嘅每個符號都有 咁大機率會同傳出嘅符號唔同(出錯)。例如係數碼電腦噉,一部數碼電腦會傳一大柞 0 同 1 做訊號,而收到訊號嘅另一部電腦會解讀呢啲碼,再將收到嘅資訊顯示俾個用家睇,一般嚟講 嘅數值低得好緊要,所以絕大多數時間收到嘅訊號都會同傳出嘅訊號一樣。

- 一條二元消除頻道[歐 21]係指一條頻道每個符號得兩個可能數值,而收到嘅每個符號都有 咁大機率會消失咗,收資訊嗰一方收到嘅每個符號都有三個可能數值:1、0 同 e 呢三款,而 e 代表消失咗(erased)噉解。消失咗代表有關嗰個符號嘅資訊完全消失唔見咗。

呀噉。

頻道容量

[編輯]喺通訊上,傳遞訊號實會用到某啲頻道,例如係將電腦連上互聯網嘅電線又或者係 Wi-Fi 呀噉,但係由現實生活觀察都知,呢啲頻道好多時都唔係完全靠得住嘅,會有雜音干擾到佢哋所傳嘅訊號,令到傳訊變得唔準。所以資訊頻道嘅運作係資訊理論實用研究上嘅一環。

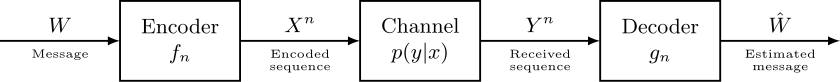

家吓想像有人用一條離散嘅頻道做緊通訊。成個過程可以想像為以下呢個模型[31]:

喺呢個模型入面, 代表所傳嘅資訊嘅空間,而 代表喺一個單位時間之內透過條頻道所收到嘅資訊嘅空間。而家將 設為「如果 嘅話, 嘅概率」, 可以想像做條頻道嘅一個固定特徵,代表咗條頻道有幾多雜音干擾:一條頻道雜音愈少,收資訊嘅人理應更加肯定佢收到嘅資訊真係表達緊傳訊人想表達嘅內容[32]。喺呢個情況下,研究者想要令到資訊(或者訊號)嘅傳送率最大化,會用 同 嘅相互資訊嚟量度資訊傳送率。如果 同 係獨立嘅,噉相互資訊會係 0,亦即係話收件人完全估唔到傳訊人講咗啲乜,而相反,如果 同 嘅相互資訊數值高,就表示 能夠準確噉話到俾人聽 係乜。一個頻道嘅最大傳送率叫做頻道容量[歐 22],可以用以下呢條式表達[31]:

頻道容量有以下嘅一個特性:假定一個細過 嘅資訊率 而編碼誤差有 咁多();只要 夠大,噉就實會有一段 咁多位元長嘅碼、大過 嘅資訊率、同埋解碼演算法能夠將出錯嘅機會率減到 以下。簡單啲講就係,只要傳緊嘅資訊率細過 就實有方法可以將出錯率變到有咁細得咁細[31]。

應用

[編輯]擬亂數

[編輯]

擬亂數產生[歐 23]喺密碼學上係一個重要課題,指啲人嘗試用電腦產生一啲類似隨機嘅數。呢一個課題喺嘥化嘅設計上好緊要,因為完全隨機嘅數字串係最難預測嘅(資訊熵最大),能夠產生近乎隨機嘅密文嘅嘥化就最安全。不過喺現實,電腦產生嘅嗰啲所謂隨機數字唔係真係隨機嘅,例如有好多電腦程式會噉樣做:

如果條方程式夠複雜,上述嘅程式所產生嘅數列望落會好似隨機嘅噉,但實際上呢串數字依然係跟住一啲決定性質嘅法則嚟運行嘅,做唔到真正嘅隨機[33]。

因為噉,密碼學方面嘅專家有好多都致力研究要點樣先至可以令產生擬亂數嗰時盡可能隨機。佢哋喺做呢啲研究嗰陣,會以令資訊熵有咁大得咁大做目標-資訊熵值高表示產生出嚟嘅數列帶有最多嘅不確定。噉即係話,資訊熵呢個資訊理論概念成為咗種有用嘅指標,等研究者可以量度產生擬亂數嘅演算法表現有幾好[34][35]。

語言學

[編輯]語言係人類用嚟互相溝通(互相傳達資訊)嘅一種重要工具,所以有唔少語言學家都著力思考點樣運用資訊理論上嘅概念了解語言學上嘅一啲現象[36]。例如呢個世界上有好多語言喺組句子嗰陣都係跟主語行先、再有動詞、最後係賓語[歐 25](SVO)噉嘅,例如係粵語同英文都跟呢個做法:

A-Ming kicks A-Chung . S V O 專有名詞 動詞 專有名詞 阿明 踢 阿松

而唔係好似例如日本話噉用主語、賓語、動詞[歐 26](SOV):

分析呢條問題嘅語言學家指出,資訊理論可以解釋到點解日本話嘅主語同賓語後面要駁唔同嘅介詞(は、を),但粵語同埋英文唔使。想像家吓有兩個人喺個好嘈嘅環境下向對方講嘢,講嘅嘢受到雜音干擾,搞到聽嗰個人聽唔清楚句句子嘅主語同賓語其中一個,如果佢哋用嘅語言係 SVO 嘅話,聽嗰個人會聽到「阿明郁腳踢」或者「郁腳踢阿松」。如果佢哋用嘅語言係 SOV 嘅話,聽嗰個人會聽到「阿明郁腳踢」或者「阿松郁腳踢」。喺前者嘅情況之下,聽嗰個人淨係靠語序就判斷到郁腳嘅係邊個人,更加能夠準確噉得到資訊[37]。另一方面,用 SOV 嘅語言就要用介詞嚟標記主語同賓語嘅分別,同時又另外搵啲方法提升自己嘅效率,等用佢哋嘅人有得準確噉傳達資訊,例如日本話就有強烈嘅語境(打前或者打後嗰句會影響一句句子嘅意思)使用。以上嘅例子顯示咗,資訊理論嘅概念幫到語言學嘅手[37][38]。

神經科學

[編輯]神經科學呢個領域專門研究神經系統,其中一個重要嘅課題係有關個腦點樣處理資訊,令到有腦嘅動物(好似係人類)曉判斷身邊有啲乜。

廿一世紀初有神經科學家做咗句假說,運用進階資訊理論當中嘅資訊最大化原則[歐 27]提倡話:個腦查實識得按照收到嘅輸入嚟自我調節,嘗試令到唔同感官(眼耳口鼻等)所俾嘅資訊最大化:喺神經科學當中,用單純嘅統計相關好多時都冇法子準確噉描述神經細胞嘅活動,因為一粒神經細胞嘅反應會同個外界刺激嘅某個特性之間有住直接嘅相關,又會同嗰個外界刺激嘅第啲特性有局部相關,關係好少可會係簡單嘅線性[歐 28](指簡單嘅正反比),所以淨係探測得到線性關係嘅統計相關冇乜用[39]。

|

於是有神經科學家就改用資訊理論當嘅相互資訊嚟做量度指標-「邊個邊個外界刺激有幾預測得到邊粒邊粒神經細胞嘅活動」:相互資訊能夠探測到非線性嘅關係,幫到手研究一粒神經細胞嘅活動同個外界刺激嘅各種特性之間嘅關係;有研究者用相互資訊做指標發現,神經細胞所射嘅動作電位(簡單講就係電訊號)會按照感官所探測到嘅外界刺激有所改變,而且改變嘅方法係傾向令到傳達嘅資訊量最大化。由呢個例子睇到,資訊理論當中嗰啲量度資訊量嘅概念幫咗手將神經科學研究嘅對象量化,令到神經科學研究變得更精確嚴謹[41][42]。

睇埋

[編輯]註釋

[編輯]歐詞

[編輯]- ↑ information

- ↑ reduction of uncertainty

- ↑ information entropy

- ↑ byte

- ↑ binary entropy function

- ↑ independent and identically distributed,iid

- ↑ joint entropy

- ↑ independent

- ↑ predicting X given the value of Y

- ↑ conditional entropy

- ↑ conditional probability

- ↑ mutual information

- ↑ symmetric

- ↑ relative entropy / Kullback–Leibler divergence

- ↑ information source

- ↑ entropy rate

- ↑ generalize

- ↑ coding theory

- ↑ data compression

- ↑ binary symmetric channel;BSC

- ↑ binary erasure channel;BEC

- ↑ channel capacity

- ↑ pseudorandom number generation

- ↑ random seed

- ↑ subject-verb-object

- ↑ subject-object-verb

- ↑ infomax principle

- ↑ linear

- ↑ default mode network

文獻

[編輯]講資訊理論嘅出名論文:

- Coupé, C., Oh, Y. M., Dediu, D., & Pellegrino, F. (2019). Different languages, similar encoding efficiency: Comparable information rates across the human communicative niche (PDF). Science Advances, 5(9), eaaw2594.

- R.V.L. Hartley, "Transmission of Information" (PDF), Bell System Technical Journal, July 1928.

- J. L. Kelly, Jr., Betbubbles.com, "A New Interpretation of Information Rate" Bell System Technical Journal, Vol. 35, July 1956, pp. 917-26.

- Andrey Kolmogorov (1968), "Three approaches to the quantitative definition of information" in International Journal of Computer Mathematics.

- R. Landauer, IEEE.org, "Information is Physical" Proc. Workshop on Physics and Computation PhysComp'92 (IEEE Comp. Sci.Press, Los Alamitos, 1993) pp. 1-4.

- R. Landauer, IBM.com, "Irreversibility and Heat Generation in the Computing Process" IBM J. Res. Dev. Vol. 5, No. 3, 1961.

- Shannon, C.E. (1948), "A Mathematical Theory of Communication" (PDF), Bell System Technical Journal, 27, pp. 379–423 & 623–656, July & October, 1948. Notes and other formats.

- Timme, N., Alford, W., Flecker, B., & Beggs, J. M. (2011). Multivariate information measures: an experimentalist's perspective. arXiv preprint arXiv:1111.6857.

講資訊理論嘅教科書:

- Arndt, C. Information Measures, Information and its Description in Science and Engineering (Springer Series: Signals and Communication Technology), 2004, ISBN 978-3-540-40855-0

- Ash, RB. Information Theory. New York: Interscience, 1965. ISBN 0-470-03445-9. New York: Dover 1990. ISBN 0-486-66521-6

- Gallager, R. Information Theory and Reliable Communication. New York: John Wiley and Sons, 1968. ISBN 0-471-29048-3

- Goldman, S. Information Theory. New York: Prentice Hall, 1953. New York: Dover 1968 ISBN 0-486-62209-6, 2005 ISBN 0-486-44271-3

- Cover, Thomas; Thomas, Joy A. (2006). Elements of information theory (2nd ed.). New York: Wiley-Interscience. ISBN 0-471-24195-4.

- Csiszar, I, Korner, J. Information Theory: Coding Theorems for Discrete Memoryless Systems Akademiai Kiado: 2nd edition, 1997. ISBN 963-05-7440-3

- MacKay, David J. C. Information Theory, Inference, and Learning Algorithms. Cambridge: Cambridge University Press, 2003. ISBN 0-521-64298-1

- Mansuripur, M. Introduction to Information Theory. New York: Prentice Hall, 1987. ISBN 0-13-484668-0

- McEliece, R. The Theory of Information and Coding. Cambridge, 2002. ISBN 978-0521831857

- Pierce, JR. An introduction to information theory: symbols, signals and noise. Dover (2nd Edition). 1961 (reprinted by Dover 1980).

- Reza, F. An Introduction to Information Theory. New York: McGraw-Hill 1961. New York: Dover 1994. ISBN 0-486-68210-2

- Shannon, Claude; Weaver, Warren (1949). The Mathematical Theory of Communication (PDF). Urbana, Illinois: University of Illinois Press. ISBN 0-252-72548-4. LCCN 49-11922.

- Stone, JV. Chapter 1 of book "Information Theory: A Tutorial Introduction", University of Sheffield, England, 2014. ISBN 978-0956372857.

- Yeung, RW. A First Course in Information Theory. Kluwer Academic/Plenum Publishers, 2002. ISBN 0-306-46791-7.

- Yeung, RW. Information Theory and Network Coding. Springer 2008, 2002. ISBN 978-0-387-79233-0.

第啲講資訊理論嘅書:

- Leon Brillouin, Science and Information Theory. Mineola, N.Y.: Dover, [1956, 1962] 2004. ISBN 0-486-43918-6

- James Gleick, The Information: A History, a Theory, a Flood. New York: Pantheon, 2011. ISBN 978-0-375-42372-7

- A. I. Khinchin, Mathematical Foundations of Information Theory. New York: Dover, 1957. ISBN 0-486-60434-9

- H. S. Leff and A. F. Rex, Editors, Maxwell's Demon: Entropy, Information, Computing. Princeton University Press, Princeton, New Jersey (1990). ISBN 0-691-08727-X

- Robert K. Logan. What is Information? - Propagating Organization in the Biosphere, the Symbolosphere, the Technosphere and the Econosphere. Toronto: DEMO Publishing.

- Tom Siegfried, The Bit and the Pendulum, Wiley, 2000. ISBN 0-471-32174-5

- Charles Seife, Decoding the Universe, Viking, 2006. ISBN 0-670-03441-X

- Jeremy Campbell, Grammatical Man. Touchstone/Simon & Schuster, 1982, ISBN 0-671-44062-4

- Henri Theil, Economics and Information Theory. Rand McNally & Company - Chicago, 1967.

- Escolano, Suau, Bonev, Information Theory in Computer Vision and Pattern Recognition. Springer, 2009. ISBN 978-1-84882-296-2

- Vlatko Vedral, Decoding Reality: The Universe as Quantum Information, Oxford University Press 2010. ISBN 0-19-923769-7

引咗

[編輯]- ↑ 1.0 1.1 1.2 Demystifying Entropy. Towards Data Science.

- ↑ David R. Anderson (November 1, 2003). "Some background on why people in the empirical sciences may want to better understand the information-theoretic methods" (PDF).

- ↑ Huelsenbeck, J. P.; Ronquist, F.; Nielsen, R.; Bollback, J. P. (2001). "Bayesian inference of phylogeny and its impact on evolutionary biology". Science. 294 (5550): 2310-2314.

- ↑ Delgado-Bonal, Alfonso; Martín-Torres, Javier (2016-11-03). "Human vision is determined based on information theory". Scientific Reports. 6 (1).

- ↑ Shannon, Claude E. (July 1948). "A Mathematical Theory of Communication". Bell System Technical Journal. 27 (3): 379-423.

- ↑ Kullback, S. (1997). Information theory and statistics. Courier Corporation.

- ↑ Bar-Hillel, Y. (1964). Language and information: Selected essays on their theory and application (p. 162). Reading: Addison-Wesley.

- ↑ Burnham, K. P. and Anderson D. R. (2002). Model Selection and Multimodel Inference: A Practical Information-Theoretic Approach, Second Edition (Springer Science, New York).

- ↑ Jaynes, E. T. (1957). "Information Theory and Statistical Mechanics". Phys. Rev. 106 (4): 620.

- ↑ F. Rieke; D. Warland; R Ruyter van Steveninck; W Bialek (1997). Spikes: Exploring the Neural Code. The MIT press.

- ↑ Thorton, C. (2013, January). A new way of linking information theory with cognitive science. In Proceedings of the Annual Meeting of the Cognitive Science Society (Vol. 35, No. 35).

- ↑ Bennett, Charles H.; Li, Ming; Ma, Bin (2003). "Chain Letters and Evolutionary Histories". Scientific American. 288 (6): 76-81.

- ↑ Allikmets, Rando; Wasserman, Wyeth W.; Hutchinson, Amy; Smallwood, Philip; Nathans, Jeremy; Rogan, Peter K. (1998). "Thomas D. Schneider], Michael Dean (1998) Organization of the ABCR gene: analysis of promoter and splice junction sequences". Gene. 215 (1): 111-122.

- ↑ Urbany, J. E., Dickson, P. R., & Wilkie, W. L. (1989). Buyer uncertainty and information search. Journal of consumer research, 16(2), 208-215.

- ↑ Galbraith, J. R. (1974). Organization design: An information processing view. Interfaces, 4(3), 28-36.

- ↑ Weary, G., & Jacobson, J. A. (1997). Causal uncertainty beliefs and diagnostic information seeking. Journal of Personality and Social Psychology, 73(4), 839.

- ↑ Griffin, E. A. (2012). A first look at communication theory/Em Griffin. New York: McGraw-Hill.

- ↑ Chen, A. H., Zhou, Y., Gong, H. Q., & Liang, P. J. (2004). Firing rates and dynamic correlated activities of ganglion cells both contribute to retinal information processing. Brain research, 1017(1-2), 13-20.

- ↑ Arndt, C. Information Measures, Information and its Description in Science and Engineering (Springer Series: Signals and Communication Technology), 2004.

- ↑ Fazlollah M. Reza (1994) [1961]. An Introduction to Information Theory. Dover Publications, Inc., New York.

- ↑ Gray, R. M. (2011), Entropy and Information Theory, Springer.

- ↑ Norman Abramson (1963), Information theory and coding. McGraw-Hill.

- ↑ 23.0 23.1 MacKay, David J. C. Information Theory, Inference, and Learning Algorithms. Cambridge: Cambridge University Press, 2003. p. 141.

- ↑ 24.0 24.1 24.2 24.3 Robert B. Ash (1990) [1965]. Information Theory. Dover Publications, Inc.

- ↑ 25.0 25.1 25.2 Cover T. M., Thomas J. A. (2006). Elements of Information Theory, 2nd Edition. New York: Wiley-Interscience.

- ↑ Kullback, S.; Leibler, R.A. (1951). "On information and sufficiency". Annals of Mathematical Statistics. 22 (1): 79-86.

- ↑ 27.0 27.1 Relative Entropy. Wolfram MathWorld.

- ↑ Jerry D. Gibson (1998). Digital Compression for Multimedia: Principles and Standards. Morgan Kaufmann.

- ↑ Einicke, G. A. (2018). "Maximum-Entropy Rate Selection of Features for Classifying Changes in Knee and Ankle Dynamics During Running". IEEE Journal of Biomedical and Health Informatics. 28 (4): 1097-1103.

- ↑ 30.0 30.1 Vera Pless (1982), Introduction to the Theory of Error-Correcting Codes, John Wiley & Sons, Inc.

- ↑ 31.0 31.1 31.2 Saleem Bhatti. "Channel capacity". Lecture notes for M.Sc. Data Communication Networks and Distributed Systems D51 -- Basic Communications and Networks.

- ↑ Hazewinkel, Michiel, ed. (2001) [1994], "Transmission rate of a channel", Encyclopedia of Mathematics, Springer Science+Business Media B.V. / Kluwer Academic Publishers, ISBN 978-1-55608-010-4.

- ↑ Gentle J.E. (2003), Random Number Generation and Monte Carlo Methods, Springer.

- ↑ Cherkaoui, A., Fischer, V., Fesquet, L., & Aubert, A. (2013, August). A very high speed true random number generator with entropy assessment. In International Workshop on Cryptographic Hardware and Embedded Systems (pp. 179-196). Springer, Berlin, Heidelberg.

- ↑ Varchola, M., & Drutarovsky, M. (2010, August). New high entropy element for FPGA based true random number generators. In International Workshop on Cryptographic Hardware and Embedded Systems (pp. 351-365). Springer, Berlin, Heidelberg.

- ↑ Coupé, C., Oh, Y. M., Dediu, D., & Pellegrino, F. (2019). Different languages, similar encoding efficiency: Comparable information rates across the human communicative niche (PDF). Science Advances, 5(9), eaaw2594.

- ↑ 37.0 37.1 Explaining the origins of word order using information theory. MIT News.

- ↑ Maynard, S. K. (1997). Japanese communication: Language and thought in context. University of Hawaii Press.

- ↑ Wang, Z., Alahmadi, A., Zhu, D., & Li, T. (2015, December). Brain functional connectivity analysis using mutual information. In 2015 IEEE Global Conference on Signal and Information Processing (GlobalSIP) (pp. 542-546). IEEE.

- ↑ Zhang, W., Muravina, V., Azencott, R., Chu, Z. D., & Paldino, M. J. (2018). Mutual Information Better Quantifies Brain Network Architecture in Children with Epilepsy. Computational and mathematical methods in medicine, 2018.

- ↑ Fairhall AL, et al. Efficiency and ambiguity in an adaptive neural code. Nature. 2001; 412(6849): 787–792.

- ↑ Sharpee TO, et al. Adaptive filtering enhances information transmission in visual cortex. Nature. 2006; 439(7079): 936–942.

拎

[編輯]- (英文) Lambert F. L. (1999), "Shuffled Cards, Messy Desks, and Disorderly Dorm Rooms - Examples of Entropy Increase? Nonsense!", Journal of Chemical Education

- (英文) IEEE Information Theory Society and ITSOC Monographs, Surveys, and Reviews.

![{\displaystyle [1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83021ecdd7307a04dbb7873affcaac031e7e935a)

![{\displaystyle S(X,Y)=\mathbb {E} _{X,Y}[-\log p(x,y)]=}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e19517393fd3d0ec1e93a7191d29c555cb47aaf1)

![{\displaystyle \mathbb {E} _{Y}[H(X|y)]=}](https://wikimedia.org/api/rest_v1/media/math/render/svg/482514f01fe869ca24130095286163f2ebd72d33)

![{\displaystyle I(X;Y)=\mathbb {E} _{X,Y}[SI(x,y)]=}](https://wikimedia.org/api/rest_v1/media/math/render/svg/120cfc24602a73c7306b4fd6cd959ab9f2b0c6d9)

![{\displaystyle [2]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aa32363c093f4cfd50ecba68068bcfd396ea8bff)