聚類分析

聚類分析(粵拼:zeoi6 leoi6 fan1 sik1;英文:cluster analysis / clustering)係一種常用嘅統計分析,目的係要令一個組(聚類)入面嘅物件彼此之間相似,但同個組以外嘅物件唔相似;精確啲講即係[1]

最基本上,聚類分析可以用附圖嗰種方法想像:圖入面拃點當中每一粒,都喺 X 軸(表示一個變數)同 Y 軸(表示另一個變數)度有個位置,但就噉用肉眼睇都睇得出,啲點可以分做三大類(唔同色嘅點),每個聚類[歐 1]都係「個聚類入面啲點,彼此之間距離近,同時又冚唪唥都係同聚類外嘅點距離遠嘅」;聚類分析就可以想像成「同啲點油顏色,表示每點屬邊個聚類」嘅過程[2][3]。

聚類分析有廣泛嘅用途:淨係講社會科學嘅話,聚類分析喺市場學上可以攞嚟將消費者分類(每位消費者做一點),從而幫手預測消費者嘅行為[4],又可以喺醫療相關工作上攞嚟按「有冇傾向做運動等健康嘅行為」將啲人(每個人做一點)分類,幫手研究「邊啲人比較傾向有食煙飲酒等唔健康嘅行為」等嘅問題[5]。因為聚類分析咁有用,由統計學以至機械學習等嘅領域,都有工作者專職研究呢種分析嘅數學特性。

篇文以下嘅內容,假設讀者已經識基礎嘅統計學。

概論

[編輯]前置概念

[編輯]聚類分析建基一個古老嘅諗頭[6]:p. 1:

| 「 | 」 |

有學者指,語言本質上就涉及類似聚類分析噉嘅諗嘢方式。例如蝴蝶呢隻詞噉:唔同蝴蝶物種之間有差異,例如齋睇啲翼嘅色水已經睇得出佢哋明顯唔同;而且同一種物種嘅蝴蝶之間都可以有個體差異,例如有啲生得大隻啲有啲生得細隻啲;但人腦留意到「呢拃物體之間嘅內部差異,明顯細過佢哋同外部嘅物件(例如人類或者大笨象)之間嘅差異」,於是人就喺腦海裏面將呢拃物件分做同一個類,並且畀個名嗌佢哋-「蝴蝶」[6]:p. 1。

統計基礎

[編輯]| 「 | 」 |

當中一個「個體」可以係(例如)一隻動物、一個人或者一隻化學元素... 呀噉都得。舉個具體例子,想像家陣有份關於健康行為嘅研究[5]:

- 研究者搵咗幾百位受試者返嚟,量度一拃同健康行為相關嘅變數-包括「每個禮拜食幾多生果蔬菜」同埋「每個禮拜食幾多垃圾食物」呀噉;

- 研究者跟住就行聚類分析,將班受試者按健康行為分聚類,佢哋事後[歐 2]再睇分析搵出嗰啲聚類喺人口統計上有啲咩共通點;

- 假想家陣研究者搵到有個聚類係「少食生果蔬菜,又多食垃圾食物嘅人」,於是佢哋進一步噉睇,睇吓個聚類入面啲人傾向係乜年齡層同性別嘅,發覺呢個聚類嘅人傾向係青少年,而男女比例大約係 1:1 咁多;

噉班研究者就搵到樣有用嘅資訊,可以作出(簡化講)「想呼籲人改善飲食習慣嗰陣,應該要以青少年做主要宣傳目標」噉嘅推論[5]。要注意嘅係,聚類分析係種探索性質[歐 3]嘅統計分析,即係話聚類分析嘅目的唔係要驗證某啲假說,而係要喺對啲聚類冇先驗知識(分析前唔知有幾多個聚類同埋每個聚類係點嘅樣)之下,搵出手上個群體有冇明確嘅聚類[註 1][9]。

X 軸表示「每個禮拜食幾多生果蔬菜」而

Y 軸表示「每個禮拜食幾多垃圾食物」

-同啲數據做聚類分析就可以答「樣本入面啲人,可唔可以按嗰兩個變數分類?」呢條問題。

聚類分析可以用多種唔同嘅演算法達致,唔同嘅聚類分析演算法可以喺以下呢啲方面彼此之間有差異[1][3]:

- 「點樣量度物件之間嘅相似度?」簡單嘅可以用歐幾里得距離或者曼克頓距離(睇下面),進階啲嘅演算法仲可以唔同變數佔嘅比重唔同[6];

- 「計好嗮物件之間嘅相似度之後,要點將佢啲分做聚類?聚類嘅具體定義係乜?」

- 「假設計好嗮相似度又定義好聚類,我哋可以由計到嘅統計顯著度作出咩推論?」

... 呀噉。因為噉,做聚類分析要求相當高嘅技術,一個人好多時要用閒閒哋幾個月嘅時間做訓練,先可以做到[8]。

相似度值

[編輯]相似度呢個概念可以話係聚類分析嘅根基。相似度係個好合符直覺嘅概念-是但搵三件物件 A B C,一個人都能夠答「A 似 B 多啲定似 C 多啲?」噉嘅問題。但喺統計學上對聚類分析嘅研究,唔同研究者用嘅相似度指標值都唔多一樣,而且呢啲唔同嘅指標,都直覺上畀人覺得係「反映得到物件之間嘅相似度」[6]:p. 2。

點之間嘅距離

[編輯]

喺數學上,距離查實係個幾撈絞嘅概念。想像家陣設兩點(一點係一個個案)叫佢哋做 同 ,每點係個向量,包含 咁多個變數(維度),噉要計嗰兩點之間嘅距離(),常用嘅計法有以下呢啲[註 2]:

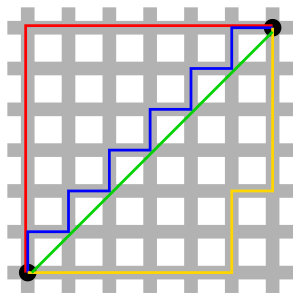

- 曼克頓計法[歐 5]:想像一個世界,兩點之間嘅空間可以用格仔代表(右圖),而且一個個體淨係有得沿住啲格仔嘅邊線嚟行,冇得穿過啲格仔(好似係一個喺曼克頓揸車搵食嘅的士司機噉),噉喺是但兩點之間穿梭都會有好多條「最短路線」,呢啲路線嘅長度就係所謂嘅曼克頓距離[11];數學化啲講,曼克頓距離計法係

要留意嘅係,上面呢幾條式「用距離嚟代表相似度」嘅做法,係假定咗啲變數冚唪唥都係連續[歐 8]嘅。有關「啲變數唔連續嗰陣,相似度要點計」呢條問題嘅答案,可以睇吓簡單匹配係數[歐 9]同埋雅卡德指數[歐 10]等嘅概念[12]。

聚類間嘅距離

[編輯]假設家陣想研究嘅變數冚唪唥都係連續嘅,而且研究者經已定義好「距離」(以下用符號 代表)嘅概念[註 3];跟住想像家陣攞兩個聚類 同 嚟睇,每個聚類都可能有 咁多點(每點係一個個案),當中 ,噉呢兩個聚類之間「有幾相似」-用符號 表示-可以用多種方法計[13]。

單連結

[編輯]單連結[歐 11]聚類距離係指 同 之間最短嘅可能距離:家吓是但由 攞一點出嚟()同埋由 攞一點出嚟(),考慮嗮所有嘅可能配對,同每對配對計嗰兩點之間嘅距離值,最後揀距離值最細嗰對配對,嗰個值就係 同 之間嘅單連結距離。數學化啲噉講即係[14][15]:

- ,當中

例如下圖條藍色線就係兩個聚類之間嘅單連結距離。單連結距離最大嘅弱點係難以分開有雜訊嘅聚類,即係例如兩個聚類之間有啲零散嘅點,就好容易會打亂段演算法計嘅數。

全連結

[編輯]全連結[歐 12]聚類距離指 同 之間最長嘅可能距離;家吓是但由 攞一點出嚟()同埋由 攞一點出嚟(),考慮嗮所有嘅可能配對,同每對配對計嗰兩點之間嘅距離值,最後揀距離值最大嗰對配對,嗰個值就係 同 之間嘅全連結距離。數學化啲噉講即係[15]:

- ,當中

例如下圖條紅色線就係兩個聚類之間嘅全連結距離。全連結距離比較應付到「聚類之間有雜訊」嘅問題,但極端數據(例如有個個案啲數值極高或者極低)容易擾亂全連結計嘅數[16][17]。

除咗單連結同全連結之外,另外一種做法係計啲點配對嘅距離值()嘅平均值呀噉。

建立聚類

[編輯]手上揸住數據,諗好「要用咩方法計相似度」之後,通常就會郁手建立聚類[18]:p. 111[19][20]。

等級聚類法

[編輯]

等級聚類法[歐 13]係最常用嘅聚類分析演算法之一。大致可以分做兩大類[13][21]:

凝聚式嘅演算法係噉嘅:一開始嗰陣當每一點(一點係一個個案)自成一個聚類,然後迴圈若干次,嘗試將拃個案結合做一個聚類,具體啲講即係噉[22]-

建立個矩陣(相似值矩陣),表示每對個案之間嘅相似值; 設每個個案自成一個聚類; 重複若干次: 結合最接近(相似值最高)嗰兩個聚類; 更新相似值矩陣; 做到淨低一個聚類為止。

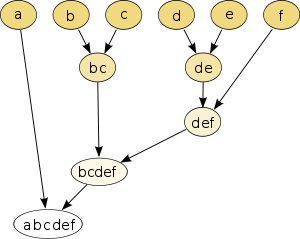

舉例說明,好似附圖嗰幅樹狀結構圖[歐 16]噉,想像家陣有 6 個個案 a b c d e f,

- 第一步將 a b c d e f 每個個案做一個聚類,

- 第二步考慮相似度數值,將 b 同 c 結合變成 bc 以及將 d 同 e 結合變成 de;

- 第三步又考慮相似度數值,將 de 同 f 結合變成 def;

- 第四步考慮相似度數值,將 bc 同 def 結合變成 bcdef;

- 最後一步,將 a 結合埋落去成一個單一聚類 abcdef;

跟住研究者就會得到一幅樹狀結構圖,可以揀喺邊個位「切割」樖樹狀結構圖,決定啲聚類要點分(下圖條粗黑線係研究者打算設嘅切割點)-例如假想第一步結合嗰兩個聚類之間嘅距離係 咁多,第二步同第三步結合嗰陣「結合咗嗰兩個聚類之間嘅距離」都係 咁上下,但第五步結合嗰陣「結合咗嗰兩個聚類之間嘅距離」係成 咁多,噉研究者好大機會會想喺第四步嗰度停手。

分割式嘅等級聚類法,簡化講可以想像成上述過程嘅相反[13]-開始嗰陣將啲個案冚唪唥當做一個聚類,每一步將「最唔相似」(例如離啲個案嘅中心點最遠)嗰個個案攞走畀佢自成一個聚類,切割到每個個案都係自成一個聚類為止,跟住畀分析者揀要喺邊一步停手[註 4][23]。

K-平均聚類法

[編輯]

K-平均聚類法[歐 17]係另一種常用嘅聚類分析演算法。K-平均聚類法嘅出發點係假定咗已知拃數據分幾多個聚類(聚類數量 )。喺最簡單嗰種情況下,K-平均聚類法可以噉嚟想像[24][25]:

- 設 做個案嘅數量而 做聚類數量;

- 建立 咁多個中心點[歐 18],每個中心點嘅位置叫 [註 5];

- 是但攞其中一個個案 嚟睇, 表示 同離佢最近嗰個 之間嘅距離;

- 慢慢調節啲中心點嘅位置[註 6],務求令啲 嘅總值有咁細得咁細[註 7][22]。

數學化啲噉講,K-平均聚類法係要將 個個案分拆做 個集(),,搵出:

K-平均聚類法亦可以用圖嚟表示。睇吓附圖幅 gif:想像家陣 ,研究者想將啲數據分做三個聚類-聚類由藍色圓圈、黃色交叉同埋紅色十字代表;當中大藍色圓圈、大黃色交叉同大紅色十字表示嗰三個聚類嘅預想中心點;K-平均聚類法就可以當成一次一次(隨住 iteration 數值上升)噉郁動三個中心點,直接達到理想數值(例如 嘅總值去到最細)為止。

中點周邊分區

[編輯]順帶一提,中點周邊分區[歐 19]係種同 K-平均聚類法好似嘅做法,最基本如下[26][27]:

- BUILD:首先,段演算法揀一點做中點[歐 20],揀嘅原則係揀成本[歐 21](可以用同其他所有點之間嘅總距離)最低嗰點;

- 重複:揀成本最低嗰點出嚟做中點,直至揀咗 點出嚟為止;

- 將每點唔屬中點嘅點,掕落離佢最近嗰粒中點度;

- SWAP:如果能夠令成本下降,一路做

PAM 唔少人用(下圖係 嘅 gif 圖解),而且好多做統計相關工作嘅人都鍾意「PAM 冇乜隨機」呢一樣嘢,不過 PAM 又畀人詬病話佢計得慢-PAM 要係噉計「呢點呢點同其他所有點之間嘅距離嘅總和」[27]。

基於分佈

[編輯]

基於分佈聚類法[歐 23]建基於概率分佈嘅諗頭,最大嘅特性係會由統計模型主導。

好似等級聚類法同 K-平均聚類法等嘅做法,都係冇任何模型喺背後[歐 24]嘅-呢啲做法唔會對「產生啲數據嘅現實過程,可以用乜數學模型嚟模擬」呢點有任何嘅假設。基於分佈聚類法就唔同-呢種做法嘅核心諗頭在於[28][29]

| 「 | 」 |

附圖展示咗基於分佈聚類法嘅根本諗頭:想像家陣三個聚類,每個聚類當係一個常態分佈(最近聚類中央嘅數值愈大機率出現)-圖入面每個深色圓圈嘅圓心係聚類中央,如果啲數據係跟常態分佈出現嘅話,愈深色嘅位會愈多個案。

基於分佈聚類法有多種唔同嘅演算法做,最基本上可以想像成[28]:

- 設 咁多個聚類;

- 攞住啲數據,用最大似然估計[歐 25]等嘅方法估計出數據背後嘅模型參數 ,例如 MLE 個做法簡單講係

- 設定嗰 個聚類嘅 ( 包括嗰個聚類中心嘅位置等嘅參數),

- 計吓喺 下「出到手上睇到嗰拃數據嘅機率」()係幾多,

- 調節吓啲參數,調節到令 有咁大得咁大為止;

- 得出理想嘅 數值之後,決定每個個案喺 之下屬邊個聚類。

基於分佈聚類法都係要事先講定 嘅數值,呢點同 K-平均聚類法一樣。

基於密度

[編輯]基於密度聚類法[歐 26]係種「唔使事先指定 嘅數值」嘅聚類分析做法(唔似得 K-平均聚類法或者中點周邊分區噉)。基於密度法由兩個參數定義[30][31]:

基於密度法最基本個諗頭係要將「密度高嘅區域」同「密度低嘅區域」分開。如果一個區域嘅個案密度高過(事先定好嘅)臨界值,先至會算係一個聚類嘅一部份,否則就會畀段演算法當係雜訊。喺 2020 年代初,DBSCAN 可以話係最多人用嘅基於密度聚類法之一,DBSCAN 步驟如下[30][31]:

- 想像有一點 ,如果佢周圍半徑 嘅範圍內超過咗 咁多點,噉佢就算係核心點[歐 27];

- 想像有兩點 同 ,如果 (兩點之間嘅距離) ,噉 算係可以由 直接去到[歐 28];順帶一提, 一定要係核心點。

- 想像有兩點 同 ,如果有條路徑 ,當中 而且 ,期間每點( 等)都可以由打前嗰點直接去到嘅,噉 算係可以由 去到[歐 29];

- 所有「唔能夠由第啲點度去到」嘅點,冚唪唥當係雜訊。

如果 係核心點,噉佢同所有由佢度去到嘅點成一個聚類。

用圖像表示嘅話,可以想像下圖:下圖 ,A 等嘅紅色點全部都係核心點,因為佢哋全部都有「周圍 咁遠嘅範圍(啲圓圈)內有超過 咁多點」呢種特性,黃色點 B 同 C 唔係核心點,但可以由 A 去到,於是啲紅色點加埋 B 同 C,就成一個聚類;藍色點 N 唔能夠由任何一點度去到,所以當係雜訊忽視。

結果核證

[編輯]做聚類分析另一個重要步驟,就係要評估場分析嘅結果,即係核證[歐 30]個結果[32][33]:現實表明,唔同聚類分析做法得出嘅結果都可能會唔同,例如同一拃數據,發覺用 嘅 K-平均聚類法會搵到個似樣嘅結果,但用凝聚式等級聚類法,得出嗰個結果係 ;為咗應付呢個問題,統計學界就有咗所謂嘅聚類分析結果指標-每種指標都會畀出一個數值(叫個數值做 ), 會客觀噉話到畀研究者知「呢個聚類結果有幾好」,例如 「 數值愈大愈表示個結果好」呀噉;噉想像研究者家吓發覺 嗰個結果(同 嗰個結果比起嚟)個 數值靚啲,噉佢就有理由揀用 嗰個結果[34][35]。

一般認為,要核證一個聚類分析結果,其中一個簡單直接嘅做法係重複場分析(睇埋再現):例如同一拃數據,用幾隻唔同嘅聚類方各行一次,睇吓係咪隻隻方法都出到相同數量嘅聚類;研究者又可以事先將拃數據斬開做兩份,同兩份數據分別噉各行一次方法一樣嘅聚類分析,睇吓兩次分析係咪都得出同一樣嘅結果... 呀噉。

評估指標

[編輯]除此之外,要評估聚類分析嘅結果,可以用一啲由數據度計出嚟嘅嘢做評估,好多時係基於一個簡單、合乎直覺嘅諗頭[36][37]:p. 115-121:

| 「 | (聚類分析定義上要做到嘅嘢) |

」 |

至於要點樣計「同聚類嘅個案之間嘅相似度」同埋「唔同聚類嘅個案之間嘅相似度」,可以有好多種做法:

- D-B 指數[歐 31]:以下呢條式出嘅數值[註 2][38]:p. 5:

- ,當中

- 係聚類嘅數量,

- 係聚類 嘅幾何中心,

- 係聚類 入面啲個案平均離 幾遠(反映個聚類嘅內部差異),

- 係聚類 同 聚類 之間嘅距離。

- D-B 指數數值低,就表示啲聚類內部差異細同埋聚類之間嘅距離大,所以一般認為 D-B 指數係數值愈細愈好。

- 頓氏指數[歐 32]:以下呢條式出嘅數值[39]:

- ,當中

- 係聚類 同 聚類 之間嘅距離,

- 係聚類 嘅內部個案間距離,

- 淺白啲講,上面條式講嘅係「 等如最細嗰個 除以最大嗰個 」。 一般認為係數值愈大愈好。

- 輪廓系數[歐 33]:想像以下嘅思路[40]:p. 3-4:

- 設 做拃數據入面嘅一個個案,而 係 所屬嗰個聚類;

- 指 大致同 入面啲個案有幾唔似(距離幾遠);

- 指 大致同 以外嘅物件有幾唔似(距離幾遠),

- 計

- 如果 淨係得 一個個案,噉 ;每個個案 數值都會喺 -1 同 1 之間(),跟住就可以考慮咁多個個案嘅平均 ,而呢個平均 值係愈近 1 愈好,而

- 係最惡劣嘅情況[40]:p. 4。

... 呀噉。有咗噉嘅指標,就有得評估聚類分析嘅結果:例如想像家陣同一拃數據,用咗 A B C 三隻唔同嘅演算法做聚類分析出三個唔同結果,但研究者發覺 A 出嘅結果 數值最低而且 數值最高,噉研究者就有理由話 A 出到嘅結果好過 B 同 C 出到嘅。

可以睇埋貝葉斯資訊量準則[歐 34]同埋赤池資訊量準則[歐 35]。

應用

[編輯]喺廿一世紀初,聚類分析廣受採用:呢種方法被指係有好多好處;首先,呢種做法可以喺內部差異嘅群體嗰度搵出幾個內部差異細嘅群體,達致有效噉簡化手上嘅數據;而經驗已經表明,手上嘅變數好少可真係彼此獨立嘅,變數間有明顯嘅相關,就表示研究者唔可以將啲變數分開噉嚟分析[7];事實表明,若干個因素夾埋一齊達到嘅效果,可以大過個別因素單獨出現嗰時達到得嘅,而聚類分析同時考慮多個因素,就唔會好似(例如)單純嘅線性迴歸分析噉畀出有誤導性嘅結果[41]。

市場學

[編輯]

市場學—研究點樣賣自己產品嘅商學—時不時都會用到聚類分析[18][42]。

市場劃分[歐 36]係市場學(尤其係市場研究)上嘅一種重要工作:好多時,一個市場入面有高嘅多樣性-唔同性別、年紀同社會階層嘅人使起錢上嚟嘅行為都會唔同;因為噉,市場學專家喺分析一個市場嗰陣,好興會將個市場按呢啲特性劃分做若干個子市場,每一個子市場內部嘅個體喺某啲特性上相近,簡單嘅例子有將個市場分做男人同女人。進階啲嘅市場劃分可以用聚類分析嚟做[43],想像-

- 市場學專家做數據收集,最簡單係做問卷調查,搵一拃消費者返嚟,每個都問佢一拃同使錢習慣有關嘅問題;

- 得出一個數據庫,個數據庫會有若干個個案(每位消費者都係一個個案),而每個個案都喺若干個變數上有數值,當中「變數」可能包括咗「每個禮拜有幾多日會去行街買嘢」、「每個月平均使幾多錢買衫」、「每個月平均使幾多錢買電腦嘢」... 呀噉;

- 對啲數據行聚類分析[44];

- 喺打後嘅分析當中,將「屬於邊個聚類」當做一個離散變數。

噉就可以得出「個市場入面,有邊幾大類嘅消費者,每類消費者啲消費行為係點」噉嘅資訊[18]。

犯罪學

[編輯]犯罪學係社會科學嘅一門,專研究犯罪行為,會思考「點樣啲人會想犯罪」同埋「點樣有效噉阻止啲人犯罪」等嘅問題[45][46]。

犯罪分析[歐 37]係犯罪學工作者成日做嘅一樣嘢,泛指對由罪案度得到嘅數據(例如每單案喺邊度發生、喺咩時間發生、犯罪者同受害者分別有咩特徵... 等等)進行分析,並且嘗試搵出犯罪行為當中有嘅規律[47]。犯罪分析好興深究罪案嘅空間特性(發生咩地點),而呢點成日會用到聚類分析,(簡化噉講)想像家陣研究者想分析謀殺案,用以下噉嘅做法[48][49]:

- 研究者參考警方數據庫等嘅來源,搵到一拃 個個案返嚟,每個個案係一單謀殺案,啲數據記錄嗮每單案係喺邊度(地圖上有座標位置)發生嘅;

- 研究者對拃數據行聚類分析;

- 最後得出一拃聚類,每個聚類都係一笪「零舍多謀殺案發生」嘅地方;

得出聚類分析結果之後,研究者就搵到拃「零舍多謀殺案發生」嘅地方,可以做進一步嘅分析,例如係再睇多啲數據,睇吓呢啲地方(喺經濟同人口特性等嘅變數上)有咩共通點,噉就有可能搵出「咩因素最會搞到一笪地方多謀殺案」呢條問題嘅答案,而呢樣資訊可以幫到犯罪學工作者手度「點樣減少謀殺案」噉嘅問題[50]。

醫療健康

[編輯]喺呢方面,有關健康行為[歐 38]嘅研究就相當出名[51]:健康心理學係心理學一門,專門將心理學上嘅概念用落醫療健康相關工作上;健康心理學其中一個最多人關注嘅課題,就係要點樣鼓勵健康行為,即係[52][53]-

| 「 | 」 |

過往嘅實驗研究表明咗,健康行為好大程度上傾向「聚埋一齊」,即係喺一樣行為上健康嘅人,傾向會喺第啲行為上都健康(即係例如食嘢食得健康嘅人,傾向都會做運動)。想像以下噉嘅研究:

- 研究會搵 位受訪者返嚟,用問卷等嘅方法問吓佢哋(例如)每個禮拜幾多餐係食垃圾食物,或者每個禮拜飲幾多酒... 呀噉;

- 數據入面有 個個案,每個個案係一位受訪者,喺「每個禮拜幾多餐係食垃圾食物」等多個變數上都有個數值;

- 研究者對拃數據行聚類分析;

- 最後得出一拃聚類,出到「成日食垃圾食物又少食生果嘅人」同「少食垃圾食物又少食生果嘅人」等多個聚類;

| 多種對健康有重大影響嘅行為 | ||||||

|---|---|---|---|---|---|---|

|

然後研究者可以做進一步嘅分析,睇吓每個聚類分別有咩特性,例如可能「成日食垃圾食物又少食生果嘅人」嗰個聚類零舍多青少年;噉研究者就可以作出「家陣想做宣傳,教啲人食得健康啲,呢啲宣傳有必要專針對青少年嚟做」呢類嘅推論。事實係,聚類分析廣泛噉畀醫療健康方面嘅工作者探究「呢類呢類群體嘅人,會唔會零舍容易有某啲唔健康行為」、「點解有啲人行為上健康啲」同埋「有冇方法可以鼓勵啲人行為上健康啲」等嘅應用問題[54]。

互聯網

[編輯]

喺互聯網相關工作上,聚類分析可以攞嚟分析社交媒體等地方嘅社會網絡[55]。

好似係對社交媒體做嘅文本探勘[歐 39]噉:社交媒體嘅用家好多時都會喺社交媒體上面留言,呢啲留言冚唪唥都係有用嘅數據,可以畀到(例如)「啲人對呢位呢位名人有咩意見」噉嘅資訊;互聯網相關嘅工作者,好多都想對呢啲數據做文本探勘(嘗試搵出文字數據當中存在嘅規律),例如可能想結合市場學上嘅分析,靠睇啲人喺社交媒體上嘅留言,得知佢哋對某隻產品有咩觀感(文本情感分析)... 呀噉[註 8];簡化講,可以想像好似以下噉嘅做法[56][57]:

- 研究者搜集咗一大拃( 咁多件)社交媒體上嘅留言返嚟,每件留言係一個個案,數據包含每段留言嘅內容(用自然語言寫嘅);

- 研究者攞住語義距離[歐 40]相關嘅技術-語義距離係自然語言處理(教電腦處理自然語言嘅技術)嘅一套技術,能夠做到攞兩隻字(input)畀出個數(output),表示嗰兩隻字之間喺意思上爭幾遠;

- 研究者用語義距離,計出每對留言之間喺意思上爭幾遠;

- 對拃數據行聚類分析;

- 最後得出一拃聚類,出到多個聚類,每個聚類可以大致當係表示緊「一套多人信嘅意見」;

順利嘅話,研究者就大致了解到「社交媒體上嘅人,按意見分可以大致分做邊幾派」,而呢樣資訊有助於市場學等嘅工作[56]。

人工智能

[編輯]人工智能(AI)係電腦科學嘅一門,專研究點樣教電腦展示出好似人噉嘅有智能行為,模擬人腦做嘅資訊處理過程[58],而正如上面所述,聚類分析响理論上就好接近人腦處理語言嗰陣嘅諗嘢方式[6]:p. 1。事實係,有唔少 AI 方面嘅工作都有用到聚類分析,即係教部電腦自動噉對某啲數據做聚類分析,得出想要嘅效果[59]。

舉例說明,異常檢測[歐 41]可以話係 AI 上最直接嘅聚類分析應用之一:異常檢測指攞一大拃個案,並且搵出啲同手上嘅大多數個案都唔同嘅異常個案,好多時係因為呢啲個案有啲可疑-例如係喺醫療上探測邊啲病人身體狀況數據(血壓同心跳率等嘅變數)異常,又或者喺金融上探測邊啲交易唔尋常(例如「短時間內出現多單交易」好多時都唔尋常,可能有詐騙)... 呀噉;教電腦自動噉做異常檢測可以將睇病或者檢查金融紀錄等嘅工作自動化[60]。

- 攞一拃過往嘅數據,呢拃數據包含咗「正常嘅電郵來往」個案同埋「有古惑嘢(例如有釣魚)嘅電郵來往」個案;

- 每個個案,啲數據都紀錄咗啲有用嘅變數描述佢,簡單嘅例如係嗰份電郵「由咩地址寄出」或者「有冇包含超連結」呀噉[63];

- 對呢啲個案做聚類分析;

- 睇吓「正常嘅電郵來往」同「有古惑嘢嘅電郵來往」可唔可以清楚噉分做兩個聚類,可以嘅話去下一步;

- 教部電腦「今後用手上嘅聚類結果,同每份電郵計吓嗰份電郵似正常多啲定係似有古惑嘢嘅多啲,有古惑嘢嘅就出警報」。

噉嘅話,就可以做到「教電腦自動噉探測邊啲電郵有異常(異常檢測)」噉嘅效果。

統計概念

[編輯]- 蝸特方法[歐 42]:等級聚類法上會用到嘅聚類間距離計法,通常會配合歐幾里得距離嚟用;喺等級聚類法嘅每一步,蝸特方法都會做以下嘅嘢[64]-

- 計個聚類嘅平均位置;

- Foreach 聚類,foreach 個聚類內部嘅物件,計件物件同個聚類嘅平均位置嘅距離;

- Foreach 第 2 步攞到嗰啲距離值,計佢嘅二次方;

- 將第 3 步攞到嗰啲數值冚唪唥加埋嗮一齊;

- 最後就會得出個數值(叫呢個值做 ),反映啲聚類內部差異有幾大,而段演算法就會以「令 有咁細得咁細」做目標,(例如)喺每步揀將邊兩個聚類結合嗰陣,揀能夠令 有咁細得咁細嗰個方案。蝸特方法廣受採用,被指能夠有效噉達致出嘅聚類個個大細相約[64]。

- 混合物模型[歐 43]:算係結構方程模型[歐 44]一種,好似聚類分析噉係一種「將數據入面啲個案分做若干組,每組內部差異細,但分析前唔知每個個案『屬邊一組』」嘅探索性質統計方法;同聚類分析嘅分別係,混合物模型唔係建基於對相似度嘅考慮,而且 output 係出「呢個呢個個案,屬呢組(每組係個潛在類別)嘅機率係咁多咁多」-唔似得聚類分析噉,會同每個個案有個明確嘅「佢屬邊個聚類」宣稱[註 9]。混合物模型會[65][66]

- 名目量度[歐 45]:行完聚類分析之後,每個個案都會多咗「屬邊個聚類」呢樣特性,呢個變數屬名目量度,可以攞嚟做進一步嘅分析,簡單嘅可以用 t 測試比較兩個聚類[52]。

- T 測試[歐 46]:可以用嚟比較兩個唔同聚類之間喺一個連續變數上有咩差異[18]:p. 111。睇埋多重比較問題同邦佛朗尼校正[歐 47]。

- 卡方檢定[歐 48]:用嚟分析名目量度型變數嘅一種統計分析法。

- 邏輯迴歸

- MANOVA

睇埋

[編輯]文獻

[編輯]- Clatworthy, J., Buick, D., Hankins, M., Weinman, J., & Horne, R. (2005). The use and reporting of cluster analysis in health psychology: A review (PDF). British journal of health psychology, 10(3), 329-358.

- Crockett, K. A., Mclean, D., Latham, A., & Alnajran, N. (2017). Cluster analysis of twitter data: A review of algorithms (PDF). In Proceedings of the 9th International Conference on Agents and Artificial Intelligence (Vol. 2, pp. 239-249). Science and Technology Publications (SCITEPRESS)/Springer Books,呢篇文綜述咗當時有嘅聚類分析演算法,攞嚟分析社交媒體上嘅留言。

- Hochin, T., Hayashi, Y., Nomiya, H., & Chowdhury, M. (2018). Quasi-optimality under pseudo F statistic in clustering data. International Journal of Engineering and Technology (UAE), 7(2), 320-324,呢篇文探討用類似方差分析(ANOVA)噉嘅方法評估聚類方案-呢套方法係想計「聚類間距離」同埋「聚類內距離」之間嘅比例(pseudo-F index),用嚟評估聚類方案。

- Landau, S., & Ster, I. C. (2010). Cluster analysis: overview (PDF). Á Á, 11(x12), x1p.

- Lloyd, S. (1982). "Least squares quantization in PCM". IEEE Transactions on Information Theory. 28 (2): 129-137.

- Marks, C., Jahangiri, A., & Machiani, S. G. (2019, October). Iterative DBSCAN (I-DBSCAN) to identify aggressive driving behaviors within unlabeled real-world driving data. In 2019 IEEE Intelligent Transportation Systems Conference (ITSC) (pp. 2324-2329). IEEE,用 DBSCAN 剖析啲人揸車,有提佢哋點決定啲參數。

- Peachavanish, R. (2016, March). Stock selection and trading based on cluster analysis of trend and momentum indicators (PDF). In Proceedings of the International MultiConference of Engineers and Computer Scientists (Vol. 1, pp. 317-321). IMECS,呢篇文提議話,唔同上市公司嘅股票可以按「近排嘅升勢」等嘅特性嚟分聚類。睇埋動量投資等嘅概念。

- Punj, G., & Stewart, D. W. (1983). Cluster analysis in marketing research: Review and suggestions for application (PDF). Journal of marketing research, 20(2), 134-148.

- Rahmah, N., & Sitanggang, I. S. (2016). Determination of optimal epsilon (eps) value on dbscan algorithm to clustering data on peatland hotspots in sumatra (PDF). In IOP conference series: earth and environmental science (Vol. 31, No. 1, p. 012012). IoP Publishing,呢篇文教人用 DBSCAN。

- Taylor, S., Lambeth, D., Green, G., Bone, R., & Cahillane, M. A. (2012). Cluster analysis examination of serial killer profiling categories: A bottom‐up approach (PDF). Journal of Investigative Psychology and Offender Profiling, 9(1), 30-51,呢篇文對連環殺人犯嘅數據進行聚類分析,想知連環殺人犯有冇得再細分做幾類。

註釋

[編輯]- ↑ 相對於(例如)郁手分類之前經已假定自己已知「類別有幾多個」嘅線性分類機。

- ↑ 2.0 2.1 有關下面啲式入面嘅數學符號係點解,可以睇吓加總、集合論、絕對值同自然數等嘅概念。

- ↑ 技術化啲噉講,研究者有可能要同每個變數計返個標準分數(),先郁手計相似度。

- ↑ 不過喺 2020 年代初,分割式嘅等級聚類法明顯比較少人用。

- ↑ 初始化嗰陣,中心點嘅位置可以隨機噉設。

- ↑ 即係好似爬山演算法等嘅最佳化做法噉。

- ↑ K-平均聚類法仲可以用第啲基準嚟界定乜先係「理想嘅中心點位置」,例如係要每個聚類內部嘅距離有咁細得咁細。

- ↑ 噉嘅分析理論上可以搵人手做,但實際應用上數據量大得滯,要用電腦程式自動化噉做先搞得掂。睇埋大數據。

- ↑ 呢點畀唔少人覺得係混合物模型同聚類分析比嘅主要缺點之一。

引咗

[編輯]- ↑ 1.0 1.1 cluster

- ↑ post hoc

- ↑ exploratory

- ↑ Euclidean distance

- ↑ Manhattan distance

- ↑ Minkowski distance

- ↑ Canberra distance

- ↑ continuous

- ↑ SMC

- ↑ Jaccard index

- ↑ single-linkage

- ↑ complete-linkage

- ↑ hierarchical clustering

- ↑ agglomerative

- ↑ divisive

- ↑ dendrogram

- ↑ k-means clustering

- ↑ cluster center

- ↑ Partitioning Around Medoids,PAM

- ↑ medoid

- ↑ cost

- ↑ converged

- ↑ distribution-based clustering

- ↑ not model-based

- ↑ MLE

- ↑ density-based clustering

- ↑ core

- ↑ directly reachable from

- ↑ reachable from

- ↑ validate

- ↑ Davies-Bouldin index,DB

- ↑ Dunn index,D

- ↑ Silhouette coefficient,s(i)

- ↑ BIC

- ↑ AIC

- ↑ market segmentation

- ↑ crime analysis

- ↑ health behaviour

- ↑ text mining

- ↑ semantic distance

- ↑ anomaly detection

- ↑ Ward's method

- ↑ mixture model

- ↑ SEM

- ↑ nominal measures

- ↑ t-test

- ↑ Bonferroni correction

- ↑ chi-square test

- ↑ 1.0 1.1 What Is Cluster Analysis? When Should You Use It For Your Results?. Qualtrics XM.

- ↑ Duran, B. S., & Odell, P. L. (2013). Cluster analysis: a survey (Vol. 100). Springer Science & Business Media.

- ↑ 3.0 3.1 Frades, I., & Matthiesen, R. (2010). Overview on techniques in cluster analysis. Bioinformatics methods in clinical research, 81-107.

- ↑ Goyat, S. (2011). The basis of market segmentation: a critical review of literature[失咗效嘅鏈] (PDF). European Journal of Business and Management, 3(9), 45-54.

- ↑ 5.0 5.1 5.2 Schneider, S., Huy, C., Schuessler, M., Diehl, K., & Schwarz, S. (2009). Optimising lifestyle interventions: identification of health behaviour patterns by cluster analysis in a German 50+ survey. European Journal of Public Health, 19(3), 271-277.

- ↑ 6.0 6.1 6.2 6.3 6.4 6.5 6.6 Landau, S., & Ster, I. C. (2010). Cluster analysis: overview (PDF). Á Á, 11(x12), x1p.

- ↑ 7.0 7.1 Backhaus, K., Erichson, B., Plinke, W., & Weiber, R. (2016). Multivariate analysemethoden (p. 145). Berlin, Heidelberg: Springer Berlin Heidelberg.

- ↑ 8.0 8.1 Estivill-Castro, Vladimir (20 June 2002). "Why so many clustering algorithms - A Position Paper". ACM SIGKDD Explorations Newsletter. 4 (1): 65-75.

- ↑ Ward Jr, J. H. (1963). Hierarchical grouping to optimize an objective function. Journal of the American statistical association, 58(301), 236-244.

- ↑ Tabak, John (2014), Geometry: The Language of Space and Form, Facts on File math library, Infobase Publishing, p. 150.

- ↑ Black, Paul E. "Manhattan distance". Dictionary of Algorithms and Data Structures. Retrieved October 6, 2019.

- ↑ Murphy, Allan H. (1996). "The Finley Affair: A Signal Event in the History of Forecast Verification". Weather and Forecasting. 11 (1): 3.

- ↑ 13.0 13.1 13.2 Understanding the concept of Hierarchical clustering Technique. Toward Data Science.

- ↑ Single-link and complete-link clustering. Stanford NLP.

- ↑ 15.0 15.1 Complete Linkage Clustering. Statistics How To.

- ↑ Milligan, G. W. (1980). An examination of the effect of six types of error perturbation on fifteen clustering algorithms. Psychometrika, 45, 325-342

- ↑ Defays, D. (1977). "An efficient algorithm for a complete link method". The Computer Journal. British Computer Society. 20 (4): 364-366.

- ↑ 18.0 18.1 18.2 18.3 Tkaczynski, A. (2017). Segmentation using two-step cluster analysis 互聯網檔案館嘅歸檔,歸檔日期2022年9月25號,. (PDF). In Segmentation in social marketing (pp. 109-125). Springer, Singapore.

- ↑ Two Step Cluster Analysis (PDF) | Arif Kamar Bafadal.

- ↑ Kent, P., Jensen, R. K., & Kongsted, A. (2014). A comparison of three clustering methods for finding subgroups in MRI, SMS or clinical data: SPSS TwoStep Cluster analysis, Latent Gold and SNOB (PDF). BMC medical research methodology, 14(1), 1-14.

- ↑ Everitt, B. S., Landau, S., and Leese, M. (2001). Cluster Analysis, 4th edn. London: Arnold.

- ↑ 22.0 22.1 Kaufman, L.; Rousseeuw, P.J. (1990). Finding Groups in Data: An Introduction to Cluster Analysis (1 ed.). New York: John Wiley.

- ↑ Everitt, B. S. and Bullmore, E. T. (1999). Mixture model mapping of brain activation in functional magnetic resonance images. Human Brain Mapping 7, 1-14.

- ↑ Tryon, Robert C. (1939). Cluster Analysis: Correlation Profile and Orthometric (factor) Analysis for the Isolation of Unities in Mind and Personality. Edwards Brothers.

- ↑ Arthur, David; Manthey, B.; Roeglin, H. (2009). "k-means has polynomial smoothed complexity". Proceedings of the 50th Symposium on Foundations of Computer Science (FOCS). arXiv:0904.1113.

- ↑ Kaufman, Leonard; Rousseeuw, Peter J. (1990-03-08), "Partitioning Around Medoids (Program PAM)", Wiley Series in Probability and Statistics, Hoboken, NJ, USA: John Wiley & Sons, Inc., pp. 68-125.

- ↑ 27.0 27.1 A deep dive into partitioning around medoids. Towards Data Science.

- ↑ 28.0 28.1 17 Clustering Algorithms Used In Data Science and Mining. Towards Data Science.

- ↑ McLachlan, G. and Peel, D. (2000). Finite Mixture Models. New York: Wiley.

- ↑ 30.0 30.1 Kriegel, Hans-Peter; Kröger, Peer; Sander, Jörg; Zimek, Arthur (2011). "Density-based Clustering". WIREs Data Mining and Knowledge Discovery. 1 (3): 231-240.

- ↑ 31.0 31.1 Ester, Martin; Kriegel, Hans-Peter; Sander, Jörg; Xu, Xiaowei (1996). "A density-based algorithm for discovering clusters in large spatial databases with noise". In Simoudis, Evangelos; Han, Jiawei; Fayyad, Usama M. (eds.). Proceedings of the Second International Conference on Knowledge Discovery and Data Mining (KDD-96). AAAI Press. pp. 226-231.

- ↑ Pfitzner, Darius; Leibbrandt, Richard; Powers, David (2009). "Characterization and evaluation of similarity measures for pairs of clusterings". Knowledge and Information Systems. Springer. 19 (3): 361-394.

- ↑ Feldman, Ronen; Sanger, James (2007-01-01). The Text Mining Handbook: Advanced Approaches in Analyzing Unstructured Data. Cambridge Univ. Press.

- ↑ Weiss, Sholom M.; Indurkhya, Nitin; Zhang, Tong; Damerau, Fred J. (2005). Text Mining: Predictive Methods for Analyzing Unstructured Information. Springer.

- ↑ Färber, Ines; Günnemann, Stephan; Kriegel, Hans-Peter; Kröger, Peer; Müller, Emmanuel; Schubert, Erich; Seidl, Thomas; Zimek, Arthur (2010). "On Using Class-Labels in Evaluation of Clusterings" (PDF). In Fern, Xiaoli Z.; Davidson, Ian; Dy, Jennifer (eds.). MultiClust: Discovering, Summarizing, and Using Multiple Clusterings.

- ↑ Manning, Christopher D.; Raghavan, Prabhakar; Schütze, Hinrich (2008-07-07). Introduction to Information Retrieval. Cambridge University Press.

- ↑ Knowledge Discovery in Databases (PDF).

- ↑ Petrovic, S. (2006, October). A comparison between the silhouette index and the davies-bouldin index in labelling ids clusters. In Proceedings of the 11th Nordic workshop of secure IT systems (Vol. 2006, pp. 53-64). Citeseer.

- ↑ Dunn, J. (1974). "Well separated clusters and optimal fuzzy partitions". Journal of Cybernetics. 4: 95-104.

- ↑ 40.0 40.1 Rousseeuw, P. J. (1987). Silhouettes: a graphical aid to the interpretation and validation of cluster analysis. Journal of computational and applied mathematics, 20, 53-65.

- ↑ 所謂嘅 synergistic effect。可以參見:Kaczynski A, Manske S, Mannell R, Grewal K: Smoking and physical activity: a systematic review. American Journal Of Health Behavior 2008, 32:93-110.

- ↑ Jaiswal, D., Kaushal, V., Singh, P. K., & Biswas, A. (2020). Green market segmentation and consumer profiling: a cluster approach to an emerging consumer market. Benchmarking: An International Journal.

- ↑ Goyat, S. (2011). The basis of market segmentation: a critical review of literature[失咗效嘅鏈] (PDF). European Journal of Business and Management, 3(9), 45-54.

- ↑ Unsupervised Learning and Data Clustering. Towards Data Science.

- ↑ Farrington, D. P., Lösel, F., Boruch, R. F., Gottfredson, D. C., Mazerolle, L., Sherman, L. W., & Weisburd, D. (2019). Advancing knowledge about replication in criminology. Journal of Experimental Criminology, 15(3), 373-396.

- ↑ Hindeland, M. J., & Weis, J. G. (1972). Personality and Self-Reported Delinquency - An Application of Cluster Analysis. Criminology, 10, 268.

- ↑ Overview of Crime Analysis (PDF). BJA, United States

- ↑ Thomson, R., Espin, J., & Samuels‐Jones, T. (2020). Green crime havens: A spatial cluster analysis of environmental crime. Social Science Quarterly, 101(2), 503-513.

- ↑ Haining, R., Wise, S., & Ma, J. (1998). Exploratory spatial data analysis. Journal of the Royal Statistical Society: Series D (The Statistician), 47(3), 457-469.

- ↑ Taylor, S., Lambeth, D., Green, G., Bone, R., & Cahillane, M. A. (2012). Cluster analysis examination of serial killer profiling categories: A bottom‐up approach (PDF). Journal of Investigative Psychology and Offender Profiling, 9(1), 30-51.

- ↑ Martin, C., Wyllie, A., & Casswell, S. (1992). Types of New Zealand drinkers and their associated alcohol-related problems. Journal of Drug Issues, 22(3), 773-796.

- ↑ 52.0 52.1 Tanton, J., Dodd, L. J., Woodfield, L., & Mabhala, M. (2015). Eating behaviours of British university students: A cluster analysis on a neglected issue. Advances in preventive medicine, 2015.

- ↑ Rayward, A. T., Duncan, M. J., Brown, W. J., Plotnikoff, R. C., & Burton, N. W. (2017). A cross-sectional cluster analysis of the combined association of physical activity and sleep with sociodemographic and health characteristics in mid-aged and older adults. Maturitas, 102, 56-61.

- ↑ Clatworthy, J., Buick, D., Hankins, M., Weinman, J., & Horne, R. (2005). The use and reporting of cluster analysis in health psychology: A review 互聯網檔案館嘅歸檔,歸檔日期2022年9月25號,. (PDF). British journal of health psychology, 10(3), 329-358.

- ↑ Yang, M. S., & Sinaga, K. P. (2019). A feature-reduction multi-view k-means clustering algorithm (PDF). IEEE Access, 7, 114472-114486.

- ↑ 56.0 56.1 Crockett, K. A., Mclean, D., Latham, A., & Alnajran, N. (2017). Cluster analysis of twitter data: A review of algorithms (PDF). In Proceedings of the 9th International Conference on Agents and Artificial Intelligence (Vol. 2, pp. 239-249). Science and Technology Publications (SCITEPRESS)/Springer Books.

- ↑ Krestel, R., Werkmeister, T., Wiradarma, T. P., & Kasneci, G. (2015, May). Tweet-recommender: Finding relevant tweets for news articles (PDF). In Proceedings of the 24th International Conference on World Wide Web (pp. 53-54).

- ↑ Winston, P. H. (1992). Artificial intelligence. Addison-Wesley Longman Publishing Co., Inc..

- ↑ Di Marco, A., & Navigli, R. (2013). Clustering and diversifying web search results with graph-based word sense induction. Computational Linguistics, 39(3), 709-754.

- ↑ Chandola, V.; Banerjee, A.; Kumar, V. (2009). "Anomaly detection: A survey". ACM Computing Surveys. 41 (3): 1-58.

- ↑ Münz, G., Li, S., & Carle, G. (2007, September). Traffic anomaly detection using k-means clustering. In GI/ITG Workshop MMBnet (Vol. 7, p. 9).

- ↑ Agrawal, S., & Agrawal, J. (2015). Survey on anomaly detection using data mining techniques (PDF). Procedia Computer Science, 60, 708-713.

- ↑ 5 Simple Tips for Phishing Email Analysis.

- ↑ 64.0 64.1 Ward, J. H., Jr. (1963), "Hierarchical Grouping to Optimize an Objective Function", Journal of the American Statistical Association, 58, 236-244.

- ↑ Weller, B. E., Bowen, N. K., & Faubert, S. J. (2020). Latent class analysis: a guide to best practice (PDF). Journal of Black Psychology, 46(4), 287-311.

- ↑ Williams, G. A., & Kibowski, F. (2016). Latent class analysis and latent profile analysis (PDF). Handbook of methodological approaches to community-based research: Qualitative, quantitative, and mixed methods, 143-151.

- ↑ Lazarsfeld, P.F. and Henry, N.W. (1968) Latent structure analysis. Boston: Houghton Mifflin.